一、引言

生成人工智能的最新进展引起了整个医学学科的极大兴趣,将计算机辅助诊断的前沿推向了新的高度。在医疗人工智能领域的广泛努力中——从视觉问答和文本总结到图像重建和翻译,甚至用于手术辅助的混合现实——我们冒险进入未知领域并问:我们能否生成动态、现实和复杂的内容,如临床内窥镜视频?

内窥镜检查是胃肠道疾病诊断、微创手术和机器人手术进展的前沿领域。尽管发挥着至关重要的作用,但内窥镜研究和培训却因视觉数据的缺乏而受到阻碍,因为用小型内窥镜捕获体内图像本身就很困难。对多样化且高质量的临床内窥镜视频集合的迫切需求凸显了医学生成人工智能突破的紧迫性。我们的目标是构建一个强大的内窥镜视频模拟器,并创建大量高质量的内窥镜视频,从而丰富医疗专业人员可用的资源,并改进手术机器人和人工智能算法的训练数据。这项令人兴奋的冒险促使我们更深入地探讨几个研究问题: ➊ 建立视频基准:医学成像和文本已经建立了基准应用程序,例如自动文本报告生成和图像重建。我们能否将这一成功扩展到医疗视频并正确衡量内窥镜模拟质量? ➋ 时空建模:虽然当前的方法可以有效地通过生成对抗网络(GAN)和扩散模型生成真实的二维临床图像,但内窥镜视频的动态性质,丰富的时空相关性,构成了重大挑战。我们的模型能否有效模拟现实生活中复杂的外科手术?

在这些问题的驱动下,我们制定了一个框架来生成空间和时间上连贯且合理的内窥镜视频,以合成真实的临床场景。与主要处理文本和 2D 图像数据的传统医疗内容生成方法不同,我们渴望为医疗领域视频生成模型的未来探索设定一个整体基准。特别是,通过为动态医疗视频精心制作我们的模型 Endora,我们探索了内窥镜视频模拟管道设计的初始经验基线(图 1)。我们进一步探索内窥镜视频生成的实验基线,其特点是全面收集临床视频,并为此目的调整现有的通用视频生成模型(第 3.1 节和第 3.2 节)。同时,我们深入研究了视频生成中评估基线的广泛维度,包括生成内容的保真度、通过数据增强提高下游视频分析的性能,以及通过生成中的多视图一致性评估的几何质量(第 3.2 节)和第 3.3 节)。

为了解决捕捉现实生活中医疗程序的时空复杂性和流动性的独特挑战,我们将先进的视频转换器架构与潜在扩散模型相结合,促进在空间和时间维度上提取远程相关性来自视频数据。特别是,训练过程涉及使用预训练的变分自动编码器将视频输入编码到潜在空间中。然后,这些编码特征通过一系列Transform block进行处理。此外,为了确保视频帧之间的一致性,我们采用了 2D 基础模型 DINO 的先验特征,这有助于从不同角度调节关键特征。我们的广泛测试表明,Endora 可以生成高度逼真的内窥镜视频,展示了其在生成具有丰富动态的医疗视频方面的有效性和潜力。简而言之,Endora 引领了创建复杂、高维手术视频内容的努力,为未来的医学生成人工智能研究树立了基准。我们的主要贡献包括:(i)引入高保真医学视频生成框架,并在内窥镜场景上进行了测试,为该领域的进一步发展奠定了基础。 (ii) 创建内窥镜视频生成的第一个公共基准,以全面收集临床视频为特色,并为此目的调整现有的通用生成视频模型。 (iii) 开发一种新技术,将从 2D 视觉基础模型中提取的特征注入生成模型,确保不同尺度的一致性和质量。 (iv) 通过在基于视频的疾病诊断和3D手术场景重建中的成功应用,展示Endora的多功能性,突显其在下游医疗任务中的潜力。

二、方法

我们训练 Endora 根据收集的实际临床观察结果生成合理的内窥镜检查视频。首先,引入扩散骨干网并将其提升到处理视频格式(第 2.1 节)。我们进一步引入了用于空间和时间建模的交错的级联变压器块(第 2.2 节)。从图像基础模型中提取先验信息,以有效指导高维复杂视频表示的生成。

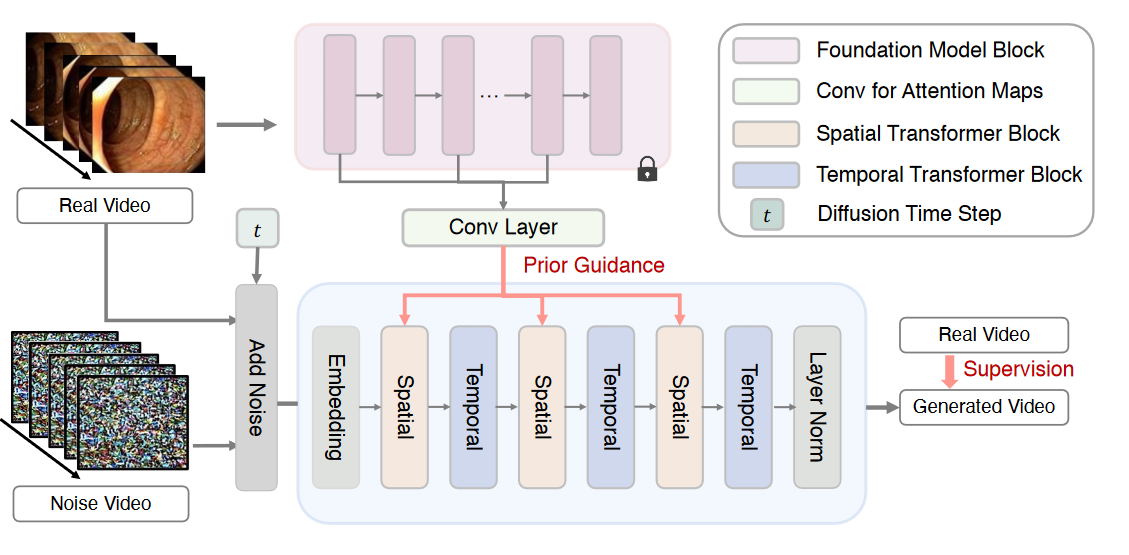

图 1:Endora 培训概述。从带噪声的输入视频序列开始,扩散模型迭代地消除噪声并恢复干净的序列。远程时空动态通过多个时空 Transformer 块的交错级联进行建模。进一步从 2D 视觉基础模型(DINO )中灌输先验知识来指导特征提取。

2.1 视频生成的扩散模型

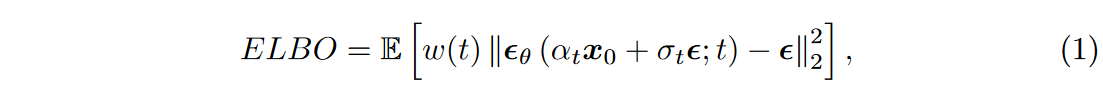

基于去噪扩散概率模型(DDPM)的生成扩散模型专门致力于将无序噪声转化为所需样本。通过逐步从高斯噪声 \(\textcolor{blue}{p(x_T)= \mathcal{N}(0, I)}\) 中去除噪声,这些模型生成与目标数据分布对齐的样本。前向扩散步骤表示为 \(\textcolor{blue}{q(x_t|x_{t-1})}\),将高斯噪声添加到图像 \(\textcolor{blue}{x_t}\) 中。相应的边缘分布可以表示为:\(\textcolor{blue}{q(x_t|x_{0}) = \mathcal{N}(\alpha_t x_0, \sigma_t^2 I)}\) 其中, \(\textcolor{blue}{\alpha_t}\) 和 \(\textcolor{blue}{\sigma_t}\)被设计为当 \(\textcolor{blue}{t}\) 到达前向过程结束时收敛到 \(\textcolor{blue}{\mathcal{N}(0, I)}\)。反向扩散过程 \(\textcolor{blue}{p(x_{t-1}|x_t)}\) 被设计为噪声估计器 \(\textcolor{blue}{\epsilon_\theta(x_t,t)}\), 用于估计噪声图像中的噪声。训练过程涉及优化加权证据下限 (ELBO),

其中 \(\textcolor{blue}{ε}\) 取自 \(\textcolor{blue}{N (0, I)}\),时间步 \(\textcolor{blue}{t}\) 遵循均匀采样,\(\textcolor{blue}{w(t)}\) 作为权重函数,其中 \(\textcolor{blue}{w(t) = 1}\)。

提升视频的扩散模型会增加计算开销和表示复杂性。潜在扩散模型在编码的潜在空间而不是像素空间中执行扩散过程,从而提高了模型效率。另一种策略是同时训练视频和图像生成以提高视频生成质量。我们在框架中采用了类似的策略,但进一步引入了下文详述的新创新。

2.2 Spatial-temporal Transformer

借鉴 ViT 对空间相关性捕获的见解,引入了一种专门从共享相同时间索引的tokens中提取空间信息的transformer作为 Spatial Transformer。我们采用Patch embedding 策略来指示该Spatial Transformer的位置嵌入。

进一步引入了Temporal Transformer来捕获跨视频帧的时间信息。我们集成了通过使用绝对位置编码策略完成的时间位置嵌入,该策略结合了不同频率的正弦函数。该策略使模型能够准确确定视频序列中每一帧的确切位置。

特别地,给定潜在空间中的视频剪辑,表示为 $ $,其中 \(\textcolor{blue}{F}\) 、\(\textcolor{blue}{H}\)、\(\textcolor{blue}{W}\) 和 \(\textcolor{blue}{C}\) 分别表示视频帧的数量、潜在特征图的高度、宽度和通道。我们将 \(\textcolor{blue}{V}\) 转换为标记序列,表示为 \(\textcolor{blue}{\hat{Z} ∈ R^{N_F×N_H×N_W×D}}\)。潜在空间中视频剪辑内的token总数为 \(\textcolor{blue}{N_F × N_H × N_W}\),\(\textcolor{blue}{D}\) 分别表示每个token的维度。时空位置嵌入 \(\textcolor{blue}{PE}\) 被集成到 \(\textcolor{blue}{\hat{Z}}\) 中。因此,\(\textcolor{blue}{Z = \hat{Z} + PE}\) 作为 Transformer 主干的输入。我们将 \(\textcolor{blue}{Z}\) 重塑为 \(\textcolor{blue}{Z^S ∈ R^{N_F×L×D}}\) 作为空间变换器块的输入,该块捕获空间信息。这里,\(\textcolor{blue}{L = N_H × N_W}\) 表示每个时间索引的token count。随后,包含空间信息的 \(\textcolor{blue}{Z^S}\) 被重塑为 \(\textcolor{blue}{Z^T ∈ R^{L×N_F×D}}\) 作为 Temporal Transformer 块的输入,用于捕获时间信息。通过交织一系列空间和时间变换器,我们的模型能够对远程空间相关性和时间动态进行全面建模。

2.3 先验引导的特征促进

与 2D 内容相比,从噪声中恢复视频帧更加困难,因为我们无法充分近似时间维度的连续性,仅限于在特定量化时间戳处采样。因此,最好优化扩散模型,使噪声序列反向投影到与人类感知一致的潜在时间连续视频空间中。为了实现这一目标,之前的工作将大语言模型(LLM)的强大功能融入到视频生成的设计中,而其他方法则使用冻结的 CLIP 编码器有效地捕获信息。然而,它们主要考虑帧之间的语义相关性,并没有充分解决帧之间的密集相关性(例如,patches、关键点),这对于更细粒度的帧连续性至关重要。

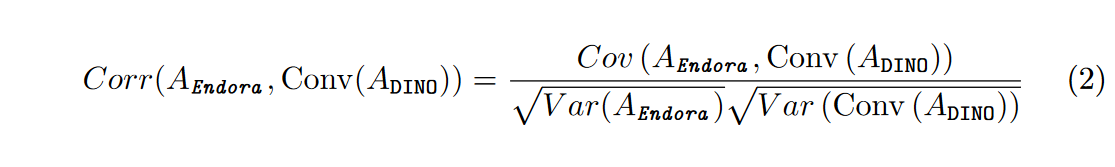

受最近通过 DINO 等视觉基础模型促进密集任务的启发,我们考虑利用 DINO 特征,因为它们不仅表现出很强的语义相关性,而且还具有提取密集对应关系的强大能力。我们建议整合 DINO 编码器产生的多尺度表示,从浅层到深层的输出,作为大规模 2D 预训练获得的先验来指导视频扩散训练。我们使用来自 DINO 的 attention map,并应用步长为 2 和 3x3 内核的卷积运算,以适应扩散注意力图的维度。考虑到 DINO 和 Endora 之间的不同机制,我们采用相对分布相似性通过 Pearson 相关性来匹配特征,

其中 \(\textcolor{blue}{A}\) 是注意力图 \(\textcolor{blue}{Cov(\cdot)}\) 是协方差,\(\textcolor{blue}{Var(\cdot)}\)是方差。我们同时最大化DINO编码器和Endora Spatial Transformer块之间的多个级别 (四层)注意图的相关性,如图1所示。在判别 DINO先验的指导下,可以彻底增强语义和空间依赖性,提高生成视频的真实感。

最后,训练 Endora 的总体优化目标是最小化公式1 和公式2 中的组合:\(\textcolor{blue}{\mathcal{L}_{DDPM} +α \mathcal{L}_{Prior} = ELBO + α(1 − Corr)}\)。我们通过网格搜索设置 \(\textcolor{blue}{α=0.5}\)。

三、实验

3.1 实验设置

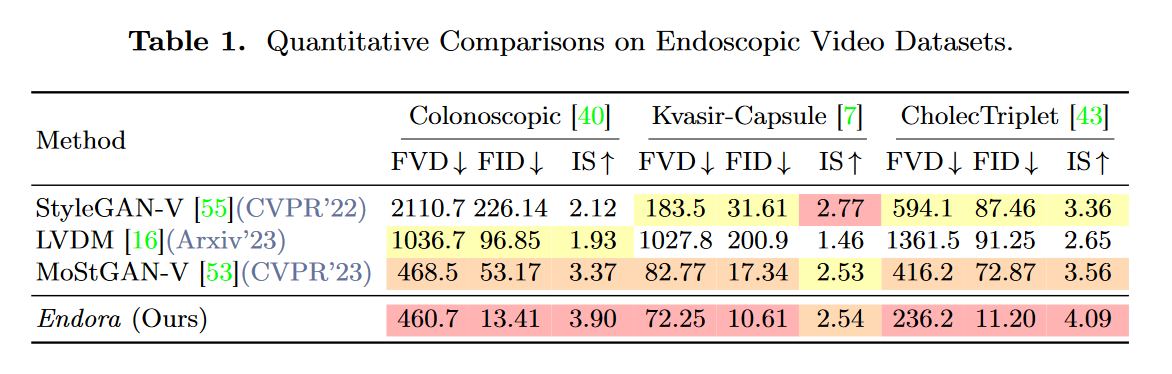

数据集和评估。我们对三个公共内窥镜视频数据集进行了全面的实验:Colonooscopy、Kvasir-Capsule、CholecTriplet 。按照惯例,我们使用特定的采样间隔从这些数据集中提取 16 帧视频剪辑,每帧大小调整为 128×128 分辨率以进行训练。在定量比较的评估中,我们采用三个评估指标:Fréchet视频距离(FVD)、Fréchet起始距离(FID)和起始分数(IS)。遵循 StyleGAN-V中的评估规则,我们通过分析 2048 个视频剪辑(每个视频剪辑包含 16 帧)来计算 FVD 分数。

实施细节。我们采用 AdamW 优化器,以 \(1 × 10^{−4}\) 的恒定学习率来训练所有模型。我们简单地将基本数据增强应用为水平翻转。遵循生成模型中的标准实践,我们使用指数移动平均(EMA)策略并报告 EMA 模型的性能以进行最终结果采样。我们直接使用来自稳定扩散的预训练变分自动编码器。我们的模型由 n = 28 个 Transformer 块构建,隐藏维度为 d = 1152,每个块中有 n = 16 个多头注意力,遵循 ViT。

对于所有三个数据集,我们对 Endora 进行了严格的训练方案,涵盖了广泛的 150, 000 个时期,以 1e − 4 的稳定学习率精心微调其参数。这项艰巨的计算工作需要 RTX 6000 的计算能力拥有惊人的 48GB 内存,可连续运行 3 天。采用提前停止策略是为了避免过度拟合,这遵循视频相关任务中的标准做法。在我们不懈追求增强 Endora 的生成能力的过程中,我们明智地定制了训练参数。我们选择局部批量大小为 5,这是经过策略性选择的,以在计算效率和模型稳定性之间取得最佳平衡。此外,为了增强生成输出的保真度,我们精心地将生成视频的尺寸设置为 [16, 128, 128],其中 16 表示包含帧数的时间范围,而 [128, 128] 表示空间分辨率每一帧图像。我们对 Endora 的实施是使用 PyTorch 框架精心设计的,利用其强大的功能来推动模型的训练和推理管道走向并行卓越。当为我们的空间块注入事先的指导时,我们战略性地整合了从 DINO 中提取的第 2、5、8 和 11 层。这些层与我们块的相应空间组件精心融合,形成了一种共生关系,丰富了我们模型收到的指导。

3.2 与最先进技术的比较

我们通过在内窥镜视频数据集上复制针对一般场景设计的几种先进视频生成模型(包括 StyleGAN-V、MoStGAN-V 和 LVDM)来进行性能比较。如表1 所示,在所有三个指标的高视觉保真度方面,Endora 优于基于 GAN 的最先进的内窥镜视频生成方法。此外,Endora 在各个方面都超越了先进的基于扩散的方法 LVDM,这表明 Endora 有效地生成了内窥镜场景的准确视频表示。

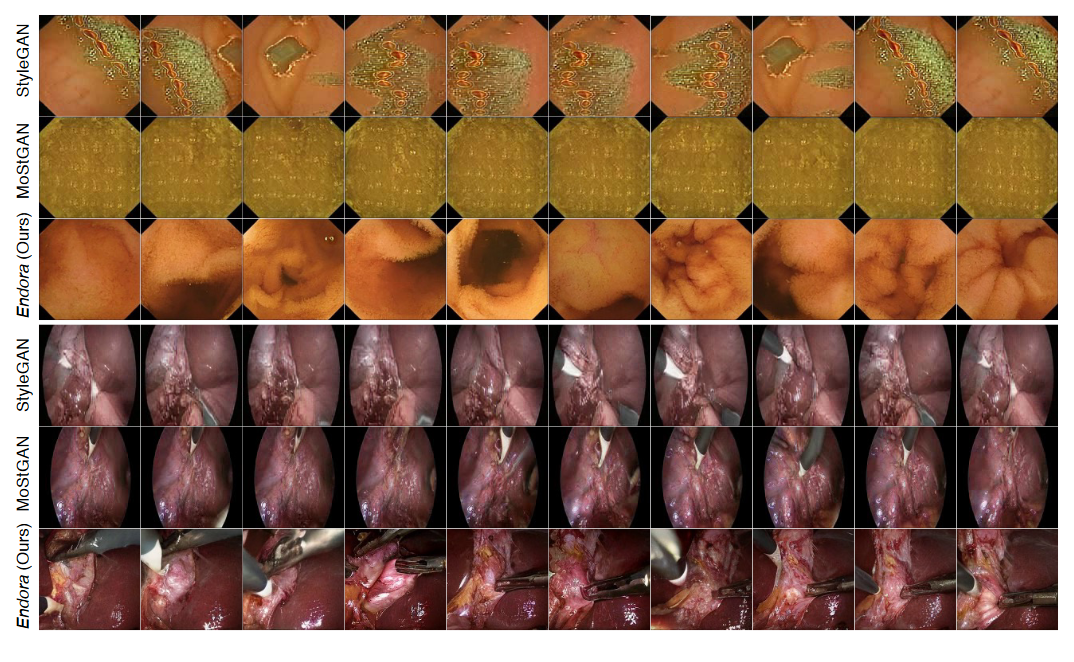

图 2 进一步展示了 Endora 和先前最先进技术的定性结果。我们可以观察到其他技术会导致视觉上不一致的扭曲(第 1 行)、受限的内容变化(第 2 行和第 4 行)以及不连续的帧间过渡(第 5 行,手术器械的突然侵入)。相比之下,Endora 生成的视频帧(第 3 行和第 6 行)避免了不一致的视觉失真(第 1 行),保留了更多视觉细节,并提供了卓越的组织视觉表示。

图 2:Kvasir-Capsule和 Cholec 数据集的定性比较。

3.3 进一步的实证研究

在本节中,我们将说明利用 Endora 生成的视频的几种潜在应用,并对我们的关键策略进行严格的消融。

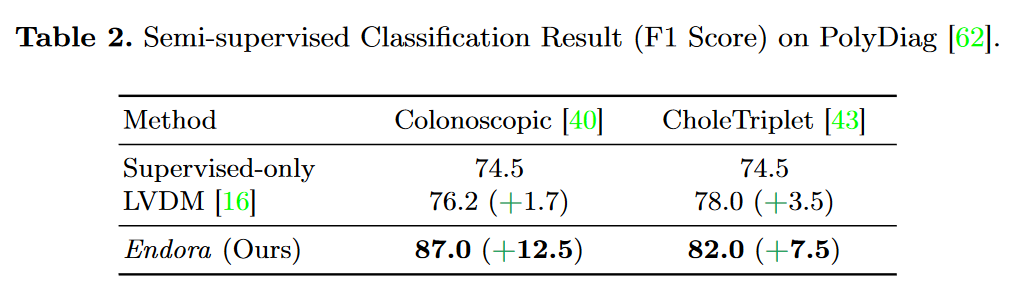

案例一:Endora 作为时间数据增强器。我们探索了在基于视频的疾病诊断基准(PolyDiag )上使用生成的视频作为半监督训练(由 FixMatch )的未标记实例的情况。特别地,我们分别使用 PolyDiag 训练集中随机选择的 \(n_l = 40\) 个视频作为标记数据,并分别使用 \(n_u = 200\) 生成的视频作为 Colonooscopy 和 CholecTriplet 中的未标记数据。表2描绘了疾病诊断的 F1 分数,仅使用标记为(仅限监督)的训练实例相对于基线的增益。结果表明,与仅监督基线以及其他视频生成方法相比,Endora 生成的数据使下游性能显着增强,证实了 Endora 作为下游视频分析的可靠视频数据增强器的功效。

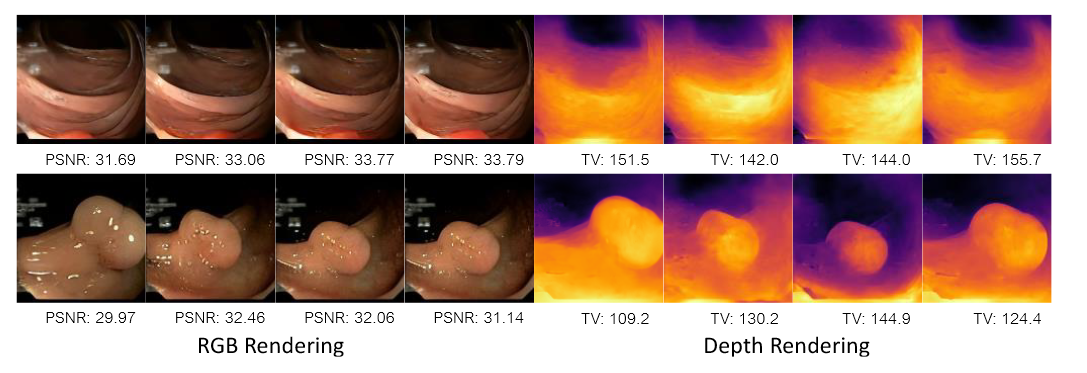

案例二:Endora 作为手术世界模拟器。生成的内容中出现的多视图一致性属性激发了我们对生成的手术视频中是否存在类似的几何一致性的探索。特别地,从生成的视频中,我们将一些帧作为 3D 重建的训练数据(训练视图),并保留其他帧作为测试数据(新视图)。然后,我们使用 COLMAP对训练视图进行预处理,然后运行现成的 3D 重建管道(EndoGaussian )以获得重建的 3D 内窥镜场景。图 3 提供了新视图下渲染的 RGB 图像和深度图的可视化,并标记了图像 PSNR 和深度方向总变化 (TV)。我们可以观察到,从生成的视频重建的 3D 场景表现出真实且连续的几何结构,显示了 Endora 以多视图一致的方式有效执行手术世界模拟的潜力

图 3:从生成的视频重建 RGB 和 3D 深度。

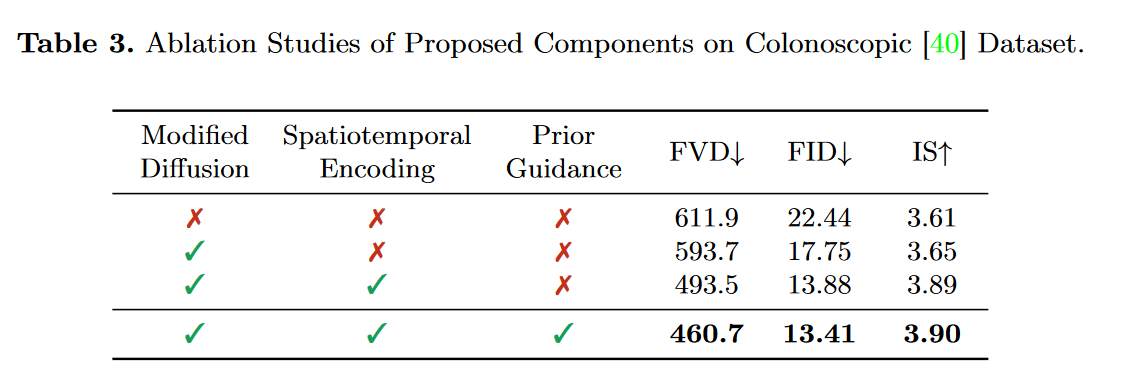

消融研究。表 3 展示了对所提议的 Endora 关键组件的消融研究。最初,我们采用简单的视频扩散模型,没有任何建议的策略作为基线。随后,我们一次添加了所提出的三种设计策略:修改扩散(第 2.1 节)、时空编码(第 2.2 节)和先验指导(第 2.3 节)。我们可以观察到它们导致模型性能的稳定进步,证实了我们设计的策略在提高内窥镜视频生成模型的整体效率和有效性方面的关键作用。

四、总结

本文介绍了 Endora,这是一种用于医疗视频生成的开创性框架,能够创建高质量、动态且逼真的内窥镜模拟。具体来说,我们利用视频转换器对视频中的远程时空关系进行建模,并利用高级 2D 视觉基础模型的先验来增强特征提取。在内窥镜视频的严格基准测试实验中,Endora 在视觉质量方面提供了卓越的结果,并且在下游视频分析模型作为数据增强器方面具有令人印象深刻的潜力。 Endora 甚至可以通过现成的内窥镜重建方法进行 3D 手术场景模拟。借助 Endora,我们在医疗生成人工智能的应用方面取得了重大进展,提供了关键见解,并为未来医疗生成内容的研究奠定了坚实的基础。