一、引言

最近,视频生成领域在合成逼真和时间连贯的视频内容方面取得了巨大进步,特别是随着扩散模型的发展。传统的基于扩散的方法,例如 videoLDM、Make-A-Video和 ModelScopeT2V,通过将额外的时间层合并到现有的图像扩散模型 [30, 31] 中来处理时间动态,已经取得了显着的性能在视频中。然而,这些基于扩散的方法不可避免地需要大量采样步骤来在推理过程中合成视频,例如 50 步 DDIM 采样 。这种限制阻碍了高质量视频的高效快速合成。

为了解决扩散模型中高采样成本的挑战,在图像生成中引入了一致性模型的概念,通过以最少的步骤实现高效的图像合成。尽管取得了成功,一致性模型在视频合成领域的应用仍然很大程度上未被探索。

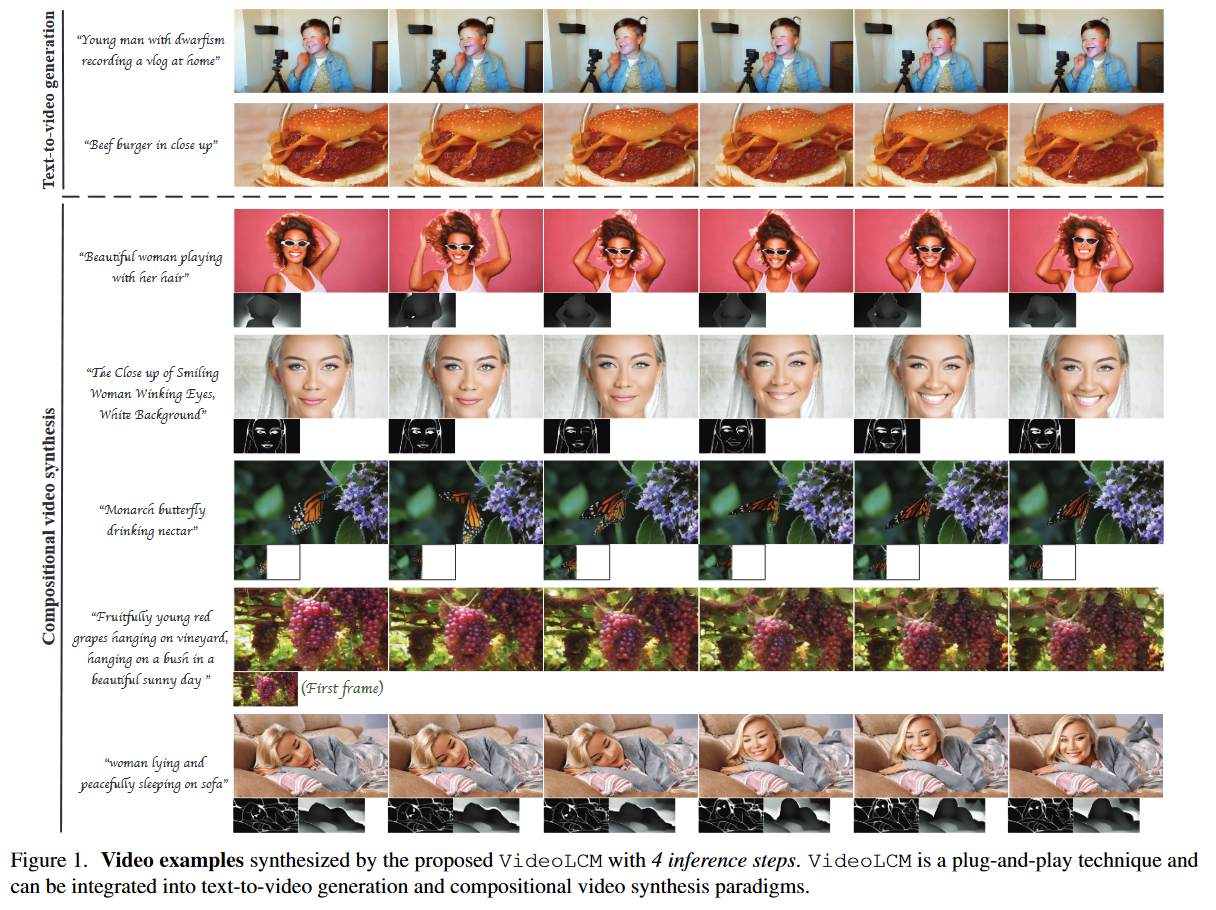

为了填补这一研究空白,作者提出了 VideoLCM 框架。该方法建立在视频生成中现有的潜在扩散模型的基础上,并利用一致性蒸馏的思想来训练视频潜在一致性模型。通过整合 VideoLCM 框架,目地为了是减少对大量采样步骤的需求,同时保持高质量的视频合成。而该方法仅用 4∼6 个采样步骤即可实现高保真视频合成,展示了其快速实时合成的潜力。

二、VideoLCM

VideoLCM模型总体框架图如图所示:

VideoLCM 的整体流程:给定源视频\(\textcolor{blue}{x_0}\),首先执行前向扩散操作以向视频添加噪声。然后,将经过噪声处理的\(\textcolor{blue}{x_{n+k}}\) 输入到学生和教师模型中以预测视频。\(\textcolor{blue}{\hat{x}_n}\) 由教师模型估计并输入 EMA 学生模型。为了学习自我一致性,施加损失来约束两个学生模型的输出保持一致。整个一致性蒸馏是在潜在空间中进行的,为了便于呈现,省略了条件指导。教师模型是视频扩散模型,学生模型与教师模型共享相同的网络结构,并使用教师模型的参数进行初始化。

在VideoLCM当中,应用DDIM作为ODE的求解器\(\textcolor{blue}{\Psi}\)去估计\(\textcolor{blue}{\hat{x}_{t_n}}\):

其中\(\textcolor{blue}{c}\)表示条件输入,可以是文本到视频生成中的文本提示或组合视频合成任务中的多个组合信号。由于无分类器指导对于合成高质量内容至关重要,因此我们还在一致性蒸馏阶段利用无分类器指导,并使用因子 \(\textcolor{blue}{w}\) 来控制指导规模:

在LCM中,\(\textcolor{blue}{w}\)是可变的,可以馈入网络进行调制,但这改变了初始网络的结构,因为需要添加编码\(\textcolor{blue}{w}\)的模块。为了保持一致性模型的初始参数和设计与教师扩散模型一致,我们用固定的\(\textcolor{blue}{w}\)值来训练一致性模型,例如9.0。请注意,无分类器指导仅适用于训练中的教师扩散模型,在一致性模型的推理过程中不需要。

VideoLCM 是一种与文本到视频生成和合成视频合成兼容的即插即用技术。在推理阶段,我们可以对 4∼6 个 LCM 步骤进行采样,以在文本到视频的生成上产生合理的结果。对于合成视频合成,以合成深度视频任务为例,2∼4步就足够了,有时甚至1步。

三、实验

1.实验设置

数据集:本文在两个广泛使用的数据集(即 WebVid10M 和 LAION5B )上训练视频一致性模型。 WebVid10M 是一个视频文本数据集,包含大约 1070 万个视频。为了进一步增强时间多样性并提高视觉质量,我们还利用约 1M 内部视频文本数据来训练 VideoLCM。 LAION-5B 是一个图像文本数据集,用于提供高质量的视觉文本对应。

实施细节:本文直接利用 TF-T2V中现有的预训练视频扩散模型作为教师模型,并在一致性蒸馏过程中固定网络参数。 TFT2V 是一种利用无文本视频来扩展视频扩散模型的技术,可应用于主流的文本到视频生成和组合视频合成框架。一致性模型的模型结构与教师扩散模型相同,并用教师的模型参数进行初始化。采用学习率为1e-5的AdamW优化器来训练VideoLCM。我们实验中使用的 EMA 率为 0.95。我们对 16 帧进行采样,并从每个源视频中裁剪 448 × 256 的中心区域作为模型输入。 VideoLCM 中使用的训练损失默认为 Huber 损失。整个网络在 4 个 NVIDIA A100 GPU 上进行训练(1 个用于图像,3 个用于视频),需要大约 4k 次训练迭代才能产生相对可靠的视频生成结果。

2.时间效率

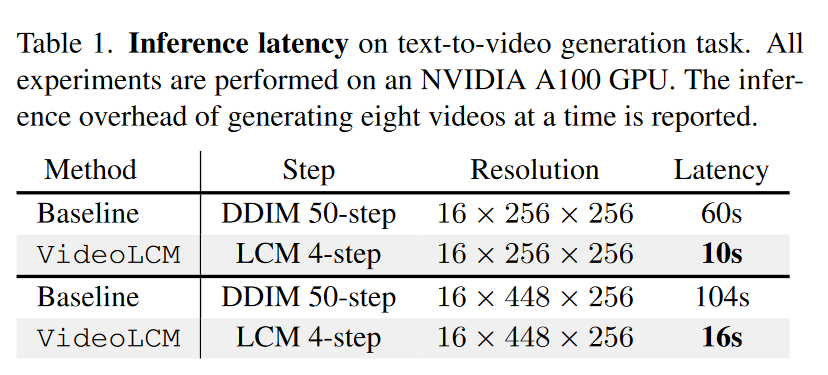

作者将他们所提出的 VideoLCM 测量文本到视频合成所需的推理时间,并将其与基线方法进行比较,比较结果如表 1 所示。

从结果中,可以观察到,VideoLCM仅需要 4 个 LCM 步骤进行推理,因此它比具有 50 个 DDIM 步骤的基线方法要快得多。值得注意的是,除了迭代去噪之外,推理成本还包括文本特征编码、潜在代码解码等。此外,我们注意到与基线相比,VideoLCM 在高分辨率生成上节省了更多时间。例如,生成 16 × 256 × 256 尺寸的视频可节省 50 秒(即 60 秒 – 10 秒),而 16x448x256 则可节省 88 秒。上述比较证明了该方法的高效率。

3.推理步骤的消融研究

在图 3 中展示了文本转视频任务中不同推理步骤的实验可视化。结果表明,当采样步长太小时,例如step = 1,生成的视频会变得模糊,许多细节无法准确表示,并且无法保留对象的时间结构。随着迭代步数的增加,视觉质量逐渐提高,并且可以更好地保持时间结构。例如,当使用4∼6步时,可以获得与DDIM的50步相当的结果,同时显着减少采样步骤并提高生成速度。

此外,作者还对合成深度到视频合成进行了消融研究。如图 4 所示,我们观察到只需几个步骤,例如 1 步,生成的结果就可以显示良好的视觉质量。随着步长的增加,许多细节变得更加明显。我们将这种现象归因于这样一个事实:与文本到视频生成相比,组合深度到视频合成可以利用额外的结构化控制信息,从而降低了从纯噪声中预测视频的难度,并能够以更少的时间实现高质量的结果。根据经验,我们发现2∼4步可以产生相对稳定的成分合成含量。文本到视频和合成视频生成的结果证明了所提出的 VideoLCM 的有效性,在质量和速度之间实现了良好的平衡。

4.更多的定性结果

为了全面展示VideoLCM方法在处理各种视频生成任务方面的能力,在图 5 中提供了额外的可视化示例。这些结果是通过 4 个 LCM 步骤生成的。从可视化结果来看,很明显,VideoLCM在视觉质量和时间连续性方面取得了令人印象深刻的生成结果。

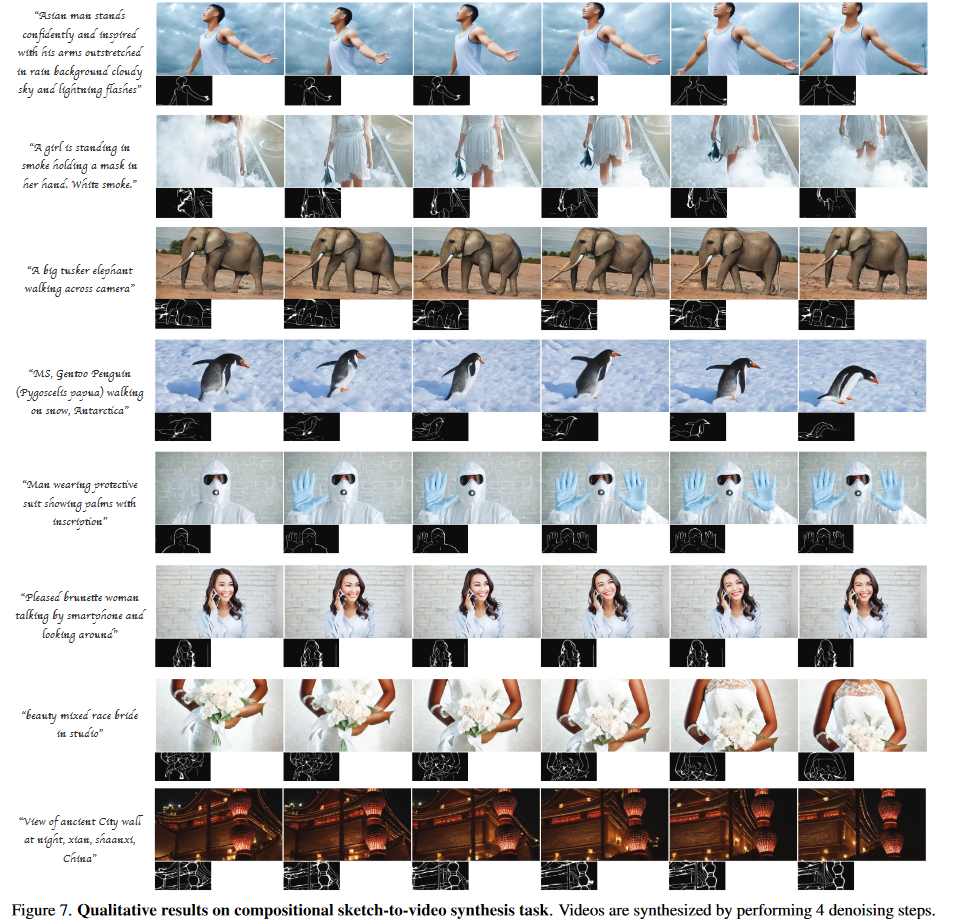

在图中。在图 6 到 8 中,展示了使用 4 个采样步骤生成合成视频的更多结果,包括合成深度到视频合成(图 6)、合成草图到视频合成(图 7)和合成视频修复(图 8)。

这些定性结果证明了稳定的生成质量,并突出了我们的方法根据输入条件的可控性。

5.限制

在VideoLCM中,探索了一致性模型在视频生成任务中的应用,包括文本到视频生成和合成视频合成。然而,存在一定的局限性:1)该方法依赖于强大的教师模型作为蒸馏目标。 2)一致性蒸馏过程需要对模型进行微调。虽然一致性蒸馏只需要少量的训练步骤,但当教师模型的训练数据不可用或来自不同领域时,可能会导致结果不令人满意。 3)尽管我们的方法将推理步骤减少到4∼6,但仍然没有实现像图像生成一样的实时视频生成。探索更加稳定、高效的视频生成算法,同时保证生成视频内容的高质量,是未来一个有前景的方向。

四、总结

在这项工作中,作者提出了 VideoLCM 框架,将潜在一致性模型扩展到视频生成领域。该方法利用现有的潜在视频扩散模型,并采用一致性蒸馏技术来实现高效、快速的视频合成。实验结果证明了我们方法的有效性,只需四个步骤即可实现高保真视频合成,与需要大约 50 个 DDIM 步骤的先前方法相比,展示了其实时合成潜力。希望VideoLCM能够作为后续研究工作的简单而有效的基线。